การรับรู้งของหุ่นยนต์เป็นประเด็นสำคัญเสมอมา ด้วยความสามารถในการตรวจจับแสง ตรวจจับภาพ หรือตรวจจับสิ่งต่าง ๆ ผ่านเซนเซอร์ทำให้หุ่นยนต์สามารถถูกสอนหรือถูกตั้งโปรแกรมในการทำงานได้ ไม่ว่าจะเป็นเซนเซอร์วัดแรง เซนเซอร์วัดอุณหภูมิ หรือกล้องตรวจจับวัตถุต่าง ๆ ล่าสุดทีมวิจัยจากมหาวิทยาลัย Cornell พัฒนาเทคโนโลยีสำหรับตรวจจับเงาจากภายในหุ่นยนต์เมื่อเกิดการสัมผัสขึ้นเพื่อรับรู้การสัมผัสของมนุษย์แล้ว

จากรายงานเอกสารการวิจัย ‘ShadowSense: Detecting Human Touch in a Social Robot Using Shadow Image Classification’ ได้ค้นพบวิธีการที่จะทำให้หุ่นยนต์สามารถตรวจจับการปฏิสัมพันธ์ทางกายภาพแบบต้นทุนต่ำได้ ไม่ว่าจะเป็นการแตะ การชก การกด การกอด ด้วยการติดตั้งกล้อง USB เอาไว้ภายในหุ่นยนต์เพื่อสังเกตกิจกรรมที่เกิดขึ้นบริเวณพื้นผิวที่มีความยืดหยุ่นและโปร่งแสงในระดับหนึ่ง

เทคโนโลยีดังกล่าวเป็นส่วนหนึ่งของการพัฒนาหุ่นยน Inflatable Robots หรือหุ่นยนต์ที่สามารถปรับเปลี่ยนรูปทรงได้ตามแรงดันภายใน (แปลตรงตัว คือ หุ่นยนต์ที่จะไม่มีวันแบน) เพื่อใช้ในสถานการณ์อพยพฉุกเฉิน หุ่นยนต์เหล่านี้ต้องสามารถสื่อสารกับมนุษย์ได้ภายใต้สภาพแวดล้อมและเงื่อนไขสุดทรหด ลองจินตนาการถึงหุ่นยนต์ที่นำทางคนผ่านเส้นทางที่เสียงดัง เต็มไปด้วยควันแต่ต้องตรวจจับมนุษย์ด้วยแรงกดที่เกิดจากมือของมนุษย์ดูก็น่าจะเห็นภาพ

หลายคนอาจคิดว่าการติดตั้งเซนเซอร์จำนวนมากอาจแก้ปัญหาได้ แต่ในความเป็นจริงแล้วจะเป็นการเพิ่มน้ำหนักรวมถึงการซับซ้อนในการเดินสายไฟ ทั้งยังเพิ่มปัญหาสำหรับภาระในการรวบรวมข้อมูลประมวลผล และเมื่อเซนเซอร์จำนวนมากเหล่านี้ต้องใช้กับพื้นผิวที่เปลี่ยนรูปร่างได้ความยากลำบากในการออกแบบใช้งานจะยิ่งยากเย็นขึ้นทวีคูณ

ด้วยวิธีคิดที่เรียบง่าย การติดตั้งกล้องภายในหุ่นยนต์เพื่อสังเกตการสัมผัสของมนุษย์และสังเกตความเจตนาที่จะเกิดขึ้นจากพฤติกรรมของเงาทำให้ปัญหาดังกล่าวเกิดโซลูชันที่เกิดขึ้นได้โดยไม่ซับซ้อน ซึ่งเทคโนโลยีนี้ยังสามรถนำไปใช้ในหุ่นยนต์ที่อยู่ในสังคมและต้องปฏิสัมพันธ์กับมนุษย์แต่ยังไม่สามารถรองรับ Touch Gestures หรือการติดตามการสัมผัสได้อีกด้วย

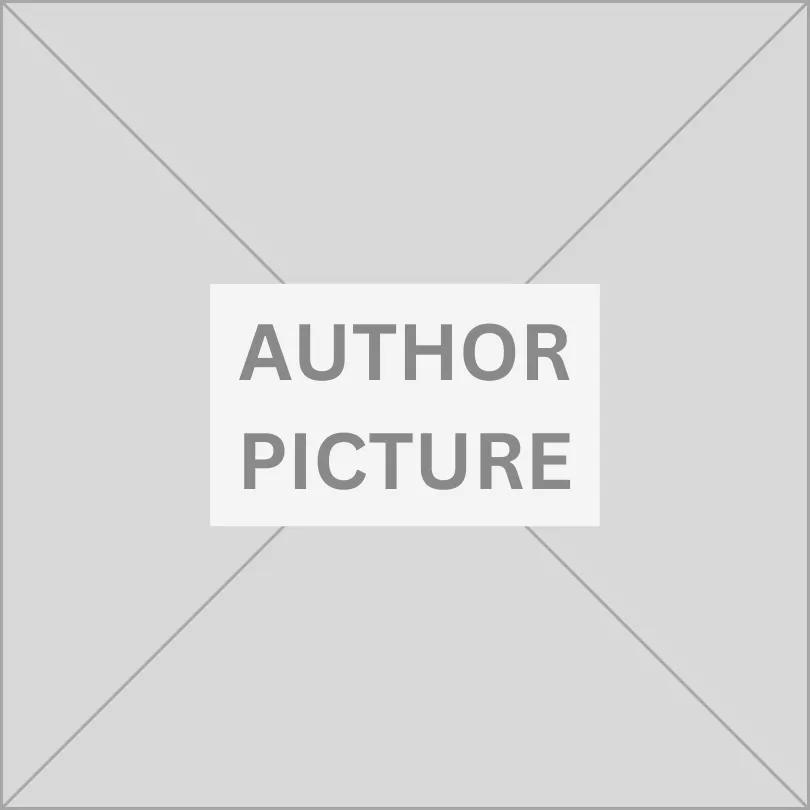

หุ่นต้นแบบนั้นประกอบไปด้วยถุงนิ่ม ๆ ที่จะไม่เกิดการรั่วซึ่งจะไม่ทำให้หุ่นยนต์แบน ผิวผลิตจากไนลอนที่ยืดหดได้รอบ ๆ โครงกระดูกทรงกระบอกที่มีความสูงประมาณ 4 ฟุต ภายใต้ผิวหนังดังกล่าวจะมีกล้อง USB ติดตั้งและเชื่อมต่อกับคอมพิวเตอร์พกพา โดยนักวิจัยได้ใช้ Neural-Network-Based Algorithm หรืออัลกอริทึ่มที่มีพื้นฐานมาจากระบบประสาทเพื่อบันทึกข้อมูลที่ฝึกระบบ มีรูปแบบการสัมผัส 6 แบบ ได้แก่ ฝ่ามือ การชก การสัมผัสด้วยสองมือ การกอด การชี้ และการไม่สัมผัสใด ๆ เลย ซึ่งความแม่นยำของการทดสอบอยู่ที่ 87.5 – 96% ขึ้นอยู่กับแสงสว่าง

หุ่นยนต์ถูกตั้งโปรแกรมให้ตอบสนองต่อรูปแบบการสัมผัสที่ตายตัว เช่น กลิ้งหนีหรือส่งข้อความผ่านลำโพง และผิวหุ่นยนต์ยังสามารถเปลี่ยนเป็นหน้าจอสำหรับปฏิสัมพันธ์ได้อีกด้วย โดยเทคโนโลยีนี้สามารถใช้กับวัสดุชนิดอื่นได้ เช่น บอลลูน โดยเปลี่ยนให้เป็นอุปกรณ์ที่ไวต่อการตอบสนองด้วยการสัมผัส

ที่มา:

Techxplore.com

| บทความที่เกี่ยวข้อง: งานวิจัยและพัฒนา เข็มทิศสู่อุตสาหกรรมที่ยั่งยืน… |