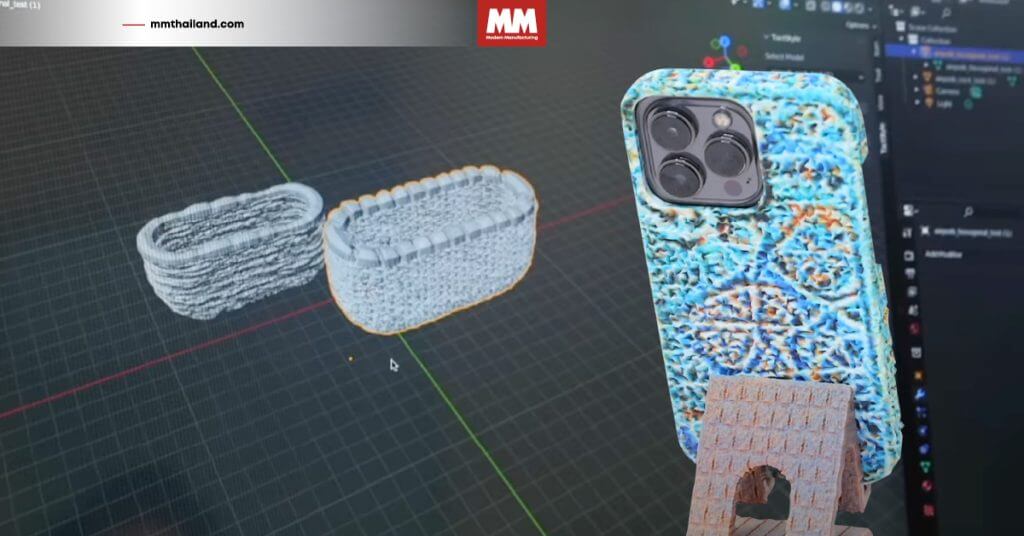

Robotic Transformer 2 (RT-2) จาก Google DeepMind เป็น โมเดล Vision-Language-Action (VLA) ที่เรียนรู้จากทั้งเว็บและข้อมูลหุ่นยนต์และเปลี่ยนแปลความรู้เหล่านี้เป็นคำแนะนำทั่วไปสำหรับการควบคุมหุ่นยนต์

โมเดลแบบ VLM หรือ Vision-Language Model นั้นเป็นการฝึกระบบด้วยชุดข้อมูลแบบ Web-Scale ทำให้ระบบมีความสามารถในการจดจำภาพหรือรูปแบบภาษาได้อย่างยอดเยี่ยม และทำงานข้ามกันไปมาระหว่างภาษาได้ แต่สำหรับหุ่นยนต์ที่จะต้องทำงานให้ได้ในระดับความสามารถเดียวกันจำเป็นต้องเก็บข้อมูลหุ่นยนต์เป็นอย่างแรก ไม่ว่าจะเป็นวัตถุทุกแบบ สภาพแวดล้อม ภาระงาน และสถานการณ์

RT-2 เป็นการต่อยอดจาก RT-1 โมเดลที่ถูกฝึกเพื่อใช้งานสำหรับการทดลองภารกิจที่หลากหลาย ด้วยการเรียนรู้ผ่านการผสมผสานระหว่าง Task และ Object ที่ถูกมองเห็นจากข้อมูลของหุ่นยนต์ ซึ่งเป็นการเก็บข้อมูลจากหุ่นยนต์ 13 ตัวเป็นเวลา 17 เดือนในสภาพแวดล้อมของห้องครัวสำนักงาน

RT-2 แสดงให้เห็นถึงความสามารถที่ทำงานได้หลากหลายมากยิ่งขึ้น ทั้งยังมีความเข้าใจก้าวไปไกลกว่าข้อมูลของที่หุ่นยนต์ได้มองเห็น ความสามารถนี้รวมถึงการตีความคำสั่งใหม่และการตอบสนองต่อคำสั่งของผู้ใช้ด้วยการพิจารณาเหตุผลและตรรกะ เช่น การใช้เหตุผลเกี่ยวกับกลุ่มประเภทวัตถุหรือคำอธิบายระดับสูง

การบูรณาการ VLMs เข้ากับการควบคุมหุ่นยนต์ทำให้เกิดความเป็นไปได้ใหม่ ๆ ขึ้น โดยทีมพัฒนาได้ทำการทดสอบ RT-2 กว่า 6,000 รูปแบบทำให้สามารถตอบสนองต่อความหลากหลายได้ดี ไม่ว่าจะเป็นวัตถุหรือสถานการณ์ที่เคยเห็นมาก่อนหรือไม่

ที่มา:

deepmind.com